〔Part 2〕英伟达在如何为VR的未来重塑显示技术管道

文章相关引用及参考:roadtovr

在本文中,我们将探索人类视觉感知的局限性,并展示英伟达正在探索的方法,希望能在未来的VR系统中提高性能

(映维网 2017年12月01日)在上一篇文章中,英伟达的摩根·麦奎尔博士向我们分享CGI,游戏和当代VR系统的现状。在本文中,我们将探索人类视觉感知的局限性,并展示英伟达正在探索的方法,希望能在未来的VR系统中提高性能。以下是映维网的整理。

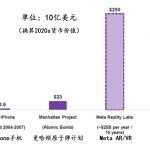

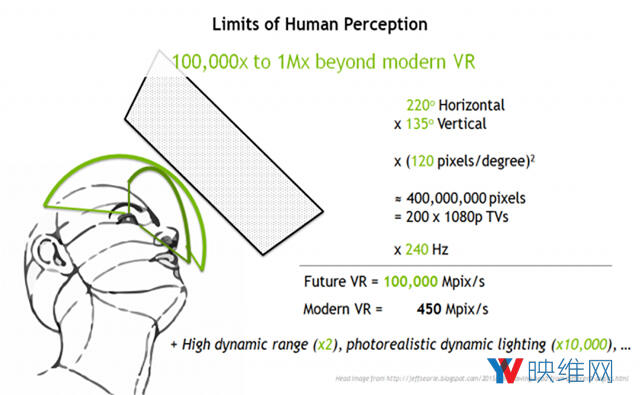

我们从人类感知的极限中推导出未来的VR规范。我们可以用不同的方法进行衡量,但对于完美的显示器,你需要大约相当于200台以240 Hz更新的高清电视。这相当于每秒图像吞吐量为1千亿像素。

回想一下,现代VR大约是450 Mpix/s。这意味着未来的VR在性能上需要增加200倍。然而,由于高动态范围,可变焦点,以及视觉质量和灯光的当前电影标准等因素,实际上的需求是1万倍的提升…而且,我们只需要1ms的延迟。

理论上我们可以通过提高计算能力来实现这个目标,但这并不高效或实惠。单纯地提高计算能力无法帮助VR实现大规模的普及。那么,什么技术可以帮助我们实现这个目标呢?

1. 渲染算法

1.1 注视点渲染

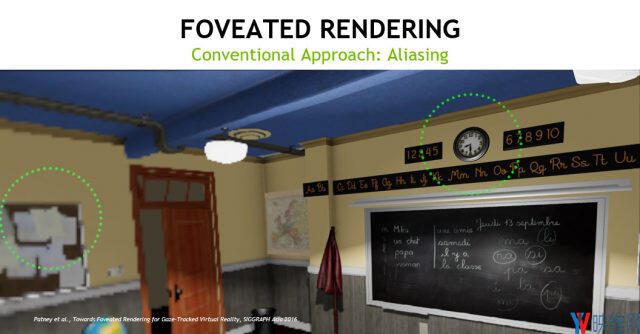

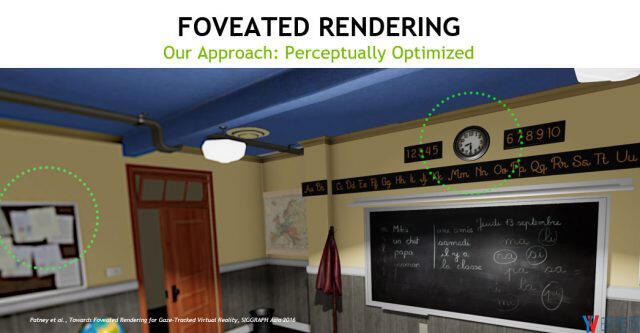

我们的第一个方法是注视点渲染技术(减少用户外围视觉的图像渲染质量),利用人类感知的原理来提高性能,并且不会导致质量的明显损失。

对眼睛而言,只有正在注视的区域才拥有高分辨率,亦即在中央凹区域。因此,VR系统可以减少外围视觉的渲染分辨率,从而提高性能。不过,它不能以低分辨率渲染。上面VR场景中的截取图。如果你注意VR场景中的时钟,位于左边的公告牌就成为了外围视觉。如上上图所示,单纯减低分辨率会产生块状图形和视觉对比度的变化。人眼在其运动过程中可以感知到这一点,或者眼睛角落会出现模糊。我们的目标是,计算生成低分辨率图像所需的精确优化量,并确保模糊能够匹配人类感知,而且外围视觉不会产生异状。

1.2 光场

为了加速渲染逼真的图形,我们正在寻找三角网格之外的渲染图元。在与麦吉尔大学和斯坦福大学的合作中,我们使用光场来加速照明计算。不同于今天的2D光照贴图(光照作用于表面上),我们面对的是是一个4D数据结构,它会以所有可能的方向和角度将光照储存于空间之中。

它们在场景中的所有表面上产生了逼真的反射和着色,甚至包括动态角色。这是将光线追踪的质量与环境探头和光照贴图的性能统一起来的下一步。

1.3 实时光线追踪

那么,真正的运行时光线追踪呢?NVIDIA Volta GPU是世界上最快的光线追踪处理器,而NVIDIA Pascal GPU则是最快的消费者版光线追踪处理器。Pascal的速度约为10亿次/秒,其速度足以取代现代VR主要的光栅器或阴影贴图(shadow map)。如果我们用刚刚描述的种种改变来解锁管道,那么光线追踪可以为未来的VR带来什么呢?

答案是:光线追踪可以为VR带来很多帮助。当你在追踪光线时,你根本不需要阴影贴图,而这将能消除潜在的障碍。光线追踪也可以单独渲染红色,绿色和蓝色,并直接为透镜渲染桶形失真(barrel-distorted)的图像。所以,它避免了透镜扭曲处理和因此造成的延迟。

实际上,光线追踪可以完全消除渲染像素离散帧的延迟,从而传统意义上“帧速率”将不复存在。一旦GPU生成像素,我们可以直接将其发送至显示器。这被称为“beam racing(波束竞速)”,而这能够去除显示同步。在这一点上,图形系统的高延迟障碍将变成零。

光栅化会产生扁平的投影平面,而光线追踪不存在这一点,因此这同时解决了视场问题。光栅化取决于3D到2D所保留的直线(如三角形的边缘)。但VR所需要的宽视场需要3D到2D的鱼眼投影,需要令三角形围绕显示器。光栅器将图像分解成多个平面来接近这一点。但通过光线追踪,如果你愿意,你甚至可以在一个球形屏幕中直接渲染一个完整的360度影像。另外,光线追踪原生支持混合图元:三角形,光场,点,体素甚至文本,这在内容优化上提供了更大的灵活性。我们正在研究如何令所有这一切比VR的传统渲染更加快速。

除了所有这些光线追踪可以加速虚拟现实渲染延迟和增加吞吐量的方法之外,光线追踪的一个主要特征在于它对图像质量的作用。在文章的第一部分中,我们谈到电影级别图像的质量主要是采用这种名为“路径追踪”的算法,而这是光线追踪的扩展。如果我们切换到基于光线的渲染器,我们将为VR开启一个全新的图像质量级别。

1.4 实时路径追踪

尽管我们现在可以实时地实现光线追踪,但实时路径追踪仍然是一个巨大的挑战。与光线追踪相比,路径追踪的计算强度大约是前者的1万倍。这就是为什么电影的每一帧都需要数分钟时间,而不是说在毫秒之间实现的原因。

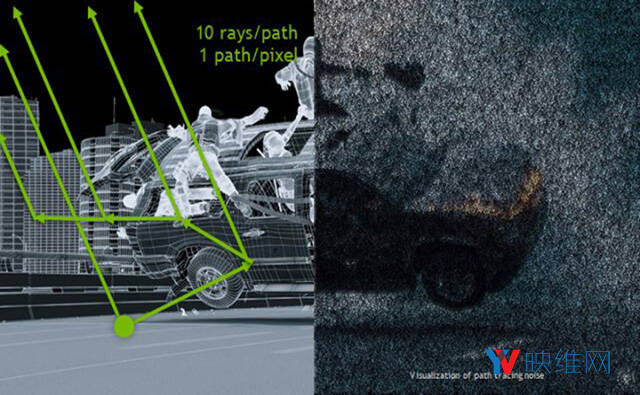

在路径追踪下,系统首先追踪来自相机的光线,以寻找可见的表面。然后再向太阳投下另一道光线,看看这个表面是否位于阴影之中。但是,场景中的照明比直接来自于太阳的光照更多。有些光线是间接光线,从地面或其他表面反弹而来。因此,路径追踪器随后会以递归方式投射另一道光线,对间接照明进行采样。这一点同样需要阴影光线投射,以及它本身的随机间接光线…继续这个过程,直至为每条单一路径追踪约10条光线。

但如果一个像素只有一条或两条路径呢,由于随机的采样过程,图像将出现大量的噪点,如下所示:

对于这个问题,电影图形的解决方案是:在每个像素上追踪数千条路径。这就是路径追踪比光线追踪的计算强度高1万倍的原因所在。

要为VR解锁路径追踪的图像质量,我们的解决方案需要仅对每个像素采样数条路径,并且仍然可以避免随机采样所造成的噪点。得益于一系列的创新,我们认为我们很快就能实现这一点,比如说注视点渲染。注视点渲染只需把重点放在图像中心的路径,并且可以将粒状图像直接转换为清晰图像,无需追踪更多的光线。

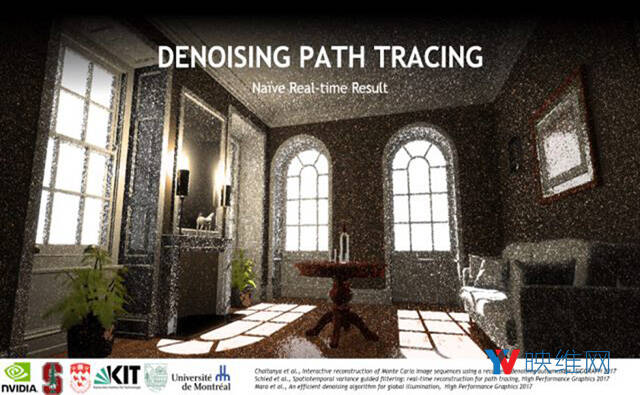

针对去噪问题,今年我们发表了三篇研究论文。这是与麦吉尔大学,蒙特利尔大学,达特茅斯学院,威廉姆斯学院,斯坦福大学和卡尔斯鲁厄理工学院合作的成果。这些方法可以将一个充满噪点的实时路径追踪图像变成如下所示:

只需毫秒的计算,没有额外的光线。我们使用的其中两种方法都利用了GPU的图像处理能力。一个是借助NVIDIA GPU的新AI处理能力。我们在神经网络上进行了长时间的去噪训练,现在它可以在数十毫秒内自行去噪图像。我们正在增加这种技术的复杂性,并且为了降低成本而进行更多的训练。这是一种令人兴奋的方法,因为我们发现可以通过意想不到的方式来使用人工智能,让AI来优化计算机图形质量,以及创建新动画3D内容以填充虚拟世界的制作过程。

2. 计算型显示器

今天VR头显中的显示器是一种相对简单的输出设备。显示器本身几乎不进行任何计算处理,只是单纯地显示传输而来的数据。尽管这对电视机,显示屏和智能手机等应用而言已经足够,但通过让显示器变得更加智能,使其不仅在显示内容上变得“聪明”,同时对用户状态的感知上变得“聪明”,我们可以进一步挖掘VR体验的性能。我们正在探索多种头显内处理,甚至是显示器内处理的方法来挑战VR的极限。

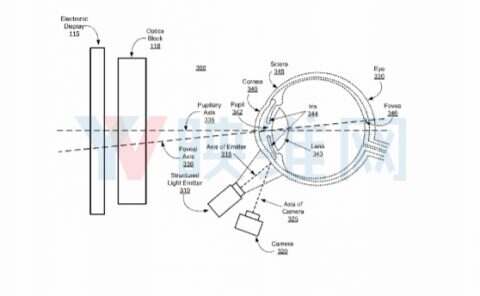

2.1 解决视觉辐辏调节冲突

VR显示器的面临的第一个挑战是聚焦问题,而这通常被称为“视觉辐辏调节冲突(vergence-accommodation disconnect/conflict)”。今天所有的VR和AR设备都强迫你聚焦于1.5米远处。有两个缺点:

- 当你在虚拟现实中看向远处或近处时,两只眼睛会聚的点与聚焦的点不匹配(看向远处,正常状态下两只眼睛的焦点分离;看向近处,正常状态下两只眼睛的焦点会聚。来回之间的眼球调节就是视觉辐辏 但当前的VR/AR设备强迫眼睛固定聚焦于一点,这时调节就会产生冲突)。这种冲突令眼睛产生不适,而这是当前VR的一个普遍问题。

- 如果你正在使用增强现实,你则是以真实的深度看向现实世界。虚拟影像需要与你所聚焦的位置相匹配,否则影像将会变得过于模糊。例如,当在驾驶期间看向20米远时,你将无法在1.5米处读取AR地图方向指示。

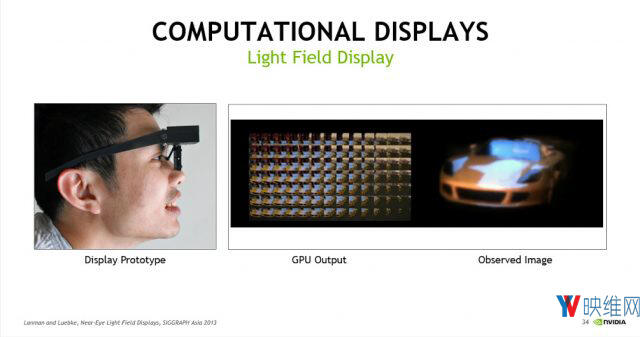

我们创建了一个计算型光场显示器原型,其可以通过多个角度呈现光线,从而允许你在任意深度进行对焦。这个显示器代表了一个重要的突破,因为计算直接在显示器中发生。我们不是发送纯粹的图像:我们正在发送复杂的数据,而显示器则将其转换成正确的形式。在上图中,看起来像是昆虫视图的小网格需要为显示器进行特殊的渲染,而这种显示器集成了自定义光学元件(微透镜阵列),能够以合适的方式显示它们,使其看起来像是正常的自然世界。

第一款光场显示器诞生于2013年。在下周的ACM SIGGRAPH Asia 2018大会上,我们将会展示一种新的全息显示器(利用激光和密集计算,在光的干扰波面上创造光场)。很难在这里展示具体的工作原理,但它依靠了相同的基本原则,并且可以产生更好的图像。

我们坚信,这种显示器内计算是未来的关键技术。不过,光场并不是我们解决焦点问题的唯一方法。我们同时创建了两种形式的可变焦点,或“变焦”光学。

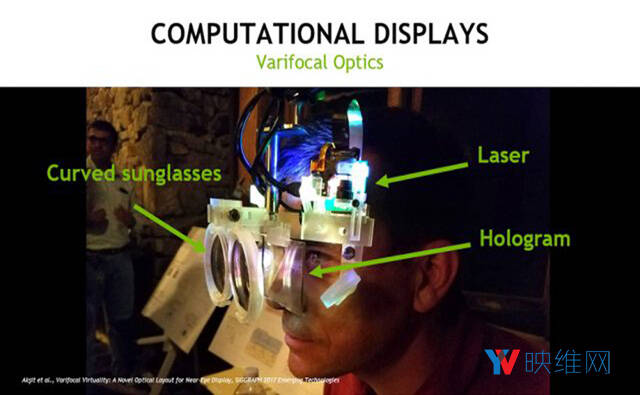

这种显示器原型使用激光将图像投影到漫射型全息图上。你直视全息图,当其从一块弧状玻璃反射回来时,你所看到的图像就像是位于远方一样:

利用一个微型马达来移动全息图或太阳眼镜反射器,我们可以控制图像出现的距离。通过匹配虚拟对象的出现距离和你在真实世界中的聚焦距离,你的眼睛就可以一直自然地进行完美对焦。

这种方法需要在显示器中进行两个计算:一个追踪用户的眼睛;另一个则计算正确的光学,从而渲染动态预扭曲的图像。与大多数原型一样,研究版本比最终产品要大得多。我们使用大型组件来促进研究建设。但对于应用于实际的优化版本,这种显示器会更像是太阳眼镜。

下面是另一个变焦原型,这是与北卡罗来纳大学,马克斯普朗克研究所和萨尔大学的研究人员合作的结果。这是一种灵活的透镜膜。随着你改变焦点,我们使用电脑控制的气动装置来改变透镜的焦距,这样视图就能保持准确。

2.2 混合云渲染

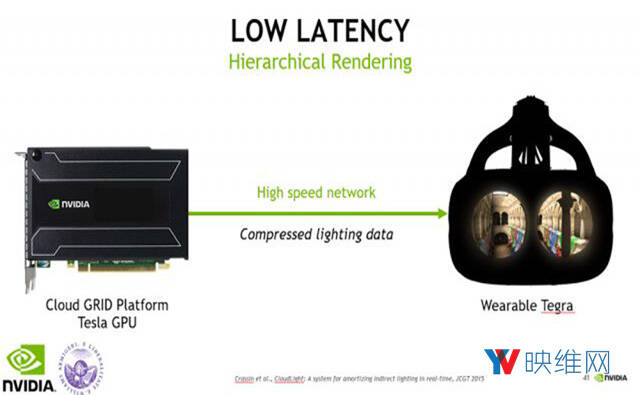

我们沿所了多种解决VR延迟挑战的新方法。其中之一是与威廉姆斯学院合作的产物,我们希望充分利用广为普及的GPU技术。为了减少渲染延迟,我们希望尽可能GPU能够尽量靠近显示器。借助Tegra移动GPU,我们甚至可以把GPU放在你的身上。但是,移动GPU的处理能力比不上桌面GPU,而且我们希望VR的图形能够优于当前的游戏图形…所以我们通过无线连接将Tegra与GeForce独显相结合,甚至更好的是,结合云端的Tesla GPU。

这使得功能强大的GPU能够计算照明信息,然后将其发送至你身边的Tegra来渲染最终的图像。在提高图像质量的同时,延迟和功耗也会减少。

2.3 降低延迟基准

当然,你无法令延迟低于帧速率。如果显示器的更新速度为90 FPS,在最糟糕的情况下延迟将不可能低于11ms,因为这是显示屏等待两帧之间的时长。所以,显示器的速度可以有多快呢?

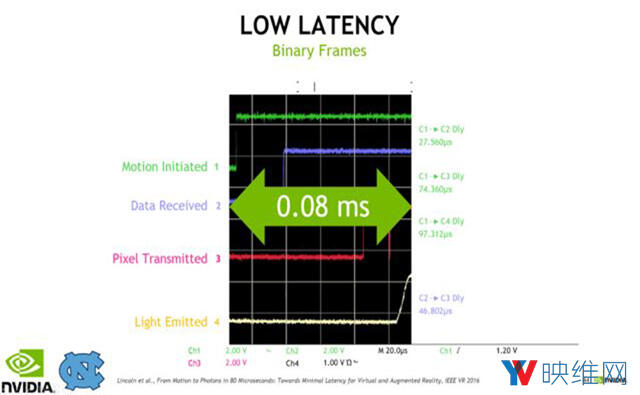

我们与北卡罗来纳大学的科学家进行了合作,构建了一台以每秒渲染1.6万张二进制帧的显示器。下图的数字示波器图表显示了这作用于头部转动的效果。当你转头时,屏幕更新的延迟将会导致晕动症。

在图表中,时间位于横轴上。当顶部的绿线跳动时,这代表了佩戴显示器的用户正在转动头部。黄线代表的是显示器更新。跳动时即为显示新图像,而时间仅仅为0.08ms…今天商业VR系统在最糟糕的情况下,这个时间为20ms,所以0.08ms比20ms足足少了大约500倍。

渲染器无法在1.6万 FPS下运行,所以为了匹配当前的头部位置,这种显示器需要依赖时间扭曲来处理大部分最新的图像。通过直接在头显内运行,我们可以加速时间扭曲过程。下面是我们的定制头显内处理器原型:

常规的时间扭曲是扭曲2D图像,更先进的时间扭曲则应用带深度的2D图像,而我们的方法则支持完整的3D数据集。上图最右边显示了一个实时扭曲完整3D场景的情形。在这个系统中,即使你在场景中四处走动,甚至其临时与渲染器断开,显示器都能保持更新。这使得我们能够以较低的速度运行渲染器,从而可以降低能耗或提高图像质量,并且在无线连接缓慢的网络中也能生成低延迟的图形。

3. 完整的系统

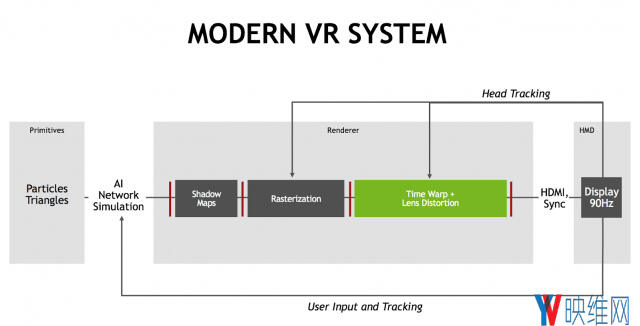

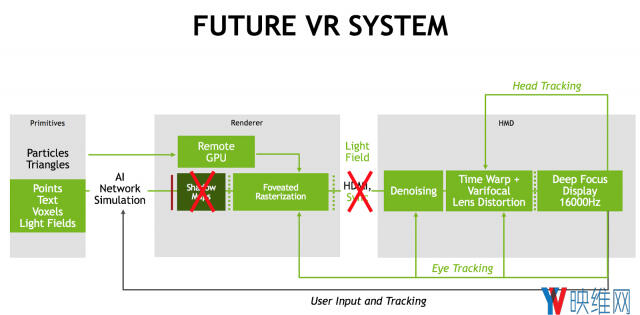

在Part 1的文章中,我们探讨了今天VR头显所应用的渲染管道:

综合上述所有技术,我们不仅可以勾勒出单独的创新,而且还能够畅想构建一个完整VR系统的愿景。这个VR系统能够去除几乎所有的同步障碍。它能够把计算扩展至云端,并直接集成至头显之内。延迟时间可以缩短50-100倍,而图像能够达到电影级别的质量。分辨率可以提高100倍,而系统只需要负责眼睛正在注视的像素即可。另外,你还能够以多种深度自然地进行聚焦。

我们正在着力提高显示器渲染图像的速度,使其几乎与现实别无二致。这种系统能够提供合适的视觉辐辏调节,一个宽广的视场,低重量和低延迟…使其成为适合日常使用的舒适而时尚的产品。

通过在计算型显示器,变焦光学,渲染,去噪,光场,二进制帧等领域的突破,英伟达研究院正在努力创新虚拟体验系统。随着系统变得更加舒适,价格变得合理,而功能变得强大,虚拟现实将成为每个人都可以使用的全新计算界面。

我所谈及的方法都可通过我们的官网进行访问。

我鼓励大家体验当今市场上的优秀VR系统。我也鼓励你加入我们,一起为AR/VR/MR的未来做贡献,并从这项技术身上认识到革命性的改变正在朝我们走来。

相关论文:Near-Eye Varifocal Augmented Reality Display using See-Through Screens