没绿幕也能做MR特效视频了,谷歌用AI实现背景分离

文章相关引用及参考:next.reality

全息视频聊天可能很快就能实现

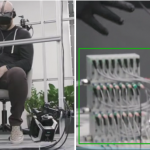

(映维网 2018年03月06日)谷歌研究团队发现了机器学习用于简化时间密集型任务的另一种方法,而这最终可以促进实现“星球大战”般的全息视频。

这项研究已经取得了成效,因为YouTube将在Stories中提供这种视频分离功能(一种类似于Snapchat的视频格式,目前仅通过有限beta版本的形式向部分创作者开放)。即便没有绿幕背景或其他设备,用户都能轻松改变他们的视频背景。

谷歌研究人员在最近的博文中介绍了神经网络如何能够实时分离视频中前景和后景的对象。负责领导项目的谷歌软件工程师Valentin Bazarevsky和Andrei Tkachenka写道:“我们的近期目标是利用在YouTube Stories中的有限推出来测试我们的技术。随着我们改进和扩大我们的分离技术,我们计划将其整合到谷歌更广泛的增强现实服务中。”

实际上,苹果的Clips应用程序已经为我们带来了这种视觉魔术。但是,Clips需要iPhone X及其原深感摄像头的加持。

谷歌的计算机视觉方法可以为更多的受众提供类似体验。这支团队设计了能够在智能手机上以高质量完成任务的卷积神经网络(CNN),其在iPhone 7上的速度达到100FPS以上,而在Pixel 2上则可以超过40FPS。

苹果和谷歌都已经展示了软件将如何帮助分离对象和背景,从而促进增强现实体验作为深度传感器的替代品。但谷歌正通过机器学习来进一步推进这一方法。由于谷歌最终着眼于AR服务,全息视频聊天可能很快就能实现。