马克斯普朗克开源项目VNect用2D摄像头实现低成本动捕

文章相关引用及参考:映维网

这是一个开源项目

(映维网 2018年05月10日)大部分应用都需要实时将用户及其运动映射至3D空间。在以前,我们只能通过昂贵的所相机系统,或者令用户穿上特殊的传感器套装才能实现。昨天映维网报道了RADiCAL的技术,现在据映维网了解(消息源:李今),马克斯普朗克计算机科学研究所的计算机科学家开发出了一种只需要单个摄像头的系统,而且它甚至可以预测用户在预录制视频中的三维姿势,比如说YouTube视频。

博士后学生Dushyant Mehta表示:“这允许通过手机来捕捉视频,同时实现身体追踪。能够实时在3D中实现这一点,而且只是借助移动设备上的摄像头,这是一个巨大的进步。”

Mehta与同事研发了只需一个传统摄像头就可以实时捕捉用户及其运动的软件系统。研究人员Srinath Sridhar解释说:“到目前为止,多摄像头系统,或者像Kinect这样深度摄像头对这项任务来说都是必不可少的工具。”

新系统基于神经网络,而研究人员将其称之为“卷积神经网络”(简称CNN),而这通常是与“深度学习”联系在一起。马克斯普朗克计算机科学研究所的研究人员开发了一种新方法,其能够借助神经网络从视频流的二维信息中计算用户的三维姿态。

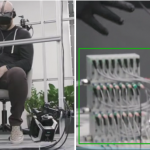

他们在官网上公布了一个演示视频。一位研究人员在后面玩杂耍,而前方的显示器则播放相应的视频录像。我们看到右边的画面叠加了一个简单的火柴人。另一个三维视图则显示了相应的运动,其用于说明研究人员能够实时捕捉完整的三维姿态。无论研究人员移动肢体的速度有多快,或者移动幅度有多大,火柴人都会进行相应的三维运动,而另一个显示器中的虚拟角色同样如此。

研究人员将他们的系统称为“VNect”。VNect既可以预测人物的三维姿态,也可以定位图人物的位置。这允许系统避免在不包含人类的图像区域上浪费计算。在机器学习过程中,系统的神经网络通过数万个注释图像进行训练。系统根据关节角度提供三维姿态信息,而这可以轻松用于控制虚拟角色。

Mehta补充说:“NVect令更广泛的人群可以触及虚拟现实的三维身体姿态追踪,因为他们不需要Kinect或其他摄像头,无需要穿戴特殊的传感器套件,只需使用十分普遍的网络摄像头即可。这同时可以为第一人称VR带来全新的体验。”除了这种交互式角色控制之外,VNect还是第一个可以用来预测视频中人物3D姿势的系统,比如说YouTube视频。马克斯普朗克计算机科学研究所的Christian Theobalt教授接着说道:“从人机交互到人类与机器人交互,再到工业4.0,这还有其他许多的应用。我们同时可以考虑自动驾驶,汽车在未来或许可以通过摄像头来预测人们的完整表达运动,然后评估他们的行为。”

但VNect仍然存在局限性。姿态估计的准确度比多相机系统或基于标记的姿态估计系统更低。如果人脸被遮挡,运动速度太快,或者出现没有训练过的姿势,系统将出现问题。另外,多用户场景也是一个问题。尽管如此,Sridhar相信技术将会进一步成熟,并且能够处理越来越复杂的场景,从而可以在日常生活中使用。

VNect是一个开源项目,目前已经有多个基于该项目的实现案例托管在GitHub上开源,更多信息可以通过他们官方网站了解。

相关论文:VNect: Real-time 3D Human Pose Estimation with a Single RGB Camera