Facebook发布『HMC实时面捕VR系统』论文

系统能够更精确地表示特定个体面容的细微差别

(映维网 2019年09月03日)Facebook Reality Labs(FRL)日前发布了实现超逼真虚拟角色的研究论文,并在其中进一步扩展了原来的“Codec Avatars”探索工作。完整的研究论文深入介绍了所述系统的方法论和数学计算。

名为“VR Facial Animation via Multiview Image Translation”的论文发布于《ACM Transactions on Graphics》期刊,而后者自称是“图形领域中最重要的同行评审期刊”。论文作者包括Shih-En Wei、Jason Saragih、Tomas Simon、Adam W. Harley、Stephen Lombardi、Michal Perdoch、Alexander Hypes、Dawei Wang、Hernan Badino和Yaser Sheikh。

对于Facebook Reality Labs创建的系统,其能够通过紧凑的硬件并以前所未有的保真度来实时动画化虚拟角色。通过头显内置的三个标准摄像头(捕捉用户的眼睛和嘴巴),系统能够更精确地表示特定个体面容的细微差别。

除了摄像头之外,这份论文同时说明了如何利用相关图像来驱动用户的虚拟化身。FRL的解决方案非常依赖于机器学习和计算机视觉。一位作者指出:“我们的系统实时运行,并且支持广泛的表情,包括气鼓鼓、咬唇、舌头运动,以及诸如皱纹等传统方法难以精确动画化的细节。”

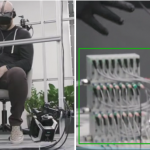

左:包含九个摄像头的“训练”头显; 右:包含三个摄像头的“追踪”头显,位置与“训练”头显相同的摄像头用红圈标识。

论文解释了项目为何要创建两个不同的实验性头显:“训练”头显和“追踪”头显。

“训练”头显体积较大,配备九个摄像头,可以捕获更大范围的对象脸部和眼睛。通过这种方式,系统可以更容易定位输入图像与先前用户数字扫描之间的“对应”(决定输入图像的哪些部分代表虚拟化身的哪些部分)。论文指出,这一过程是“通过自我监督的多视图图像转换自动发现,无需手动注释域之间的一对一对应”。

一旦建立了对应关系,更紧凑的“追踪”头显就可以派上用场。它的三个摄像头与“训练”头显中的九个摄像头中的三个对齐。得益于“训练”头显收集的数据,系统可以更好地理解这三个摄像头的视图,并使得输入能够精确地驱动虚拟化身的动画。

论文的主要笔墨都用在了系统的精度方面。先前的方法能够创建逼真的输出,但用户实际面容关键区域中的精度存在问题,尤其是夸张表情,以及眼睛所行和嘴巴所行之间的关系。

如果细细思考实际发生的事情,你会发现这实际上非常令人赞叹:尽管头显遮挡了用户的大部分面容,但系统依然能够利用超近距离的摄像头视图来精确重建用户的未遮挡视图。

尽管令人印象深刻,但这种方法存在影响主流普及的主要障碍。研究十分依赖于前期对用户的精细扫描和“训练”头显的首先应用,而这显然需要Facebook提供某种“扫描中心”,从而支持用户扫描和训练虚拟角色(甚至需要定制的HRTF)。在VR成为社会交流方式的重要支柱之前,这种中心似乎都是不可行的方案。但随着的技术的不断发展和对应确定自动化的持续优化,我们最终或许可以直接在家中完成相关的操作。