谷歌在CVPR2020分享最新AR/VR研究成果

最新的研究进展

(映维网 2020年06月18日)2020年计算机视觉和模式识别大会(Conference on Computer Vision and Pattern Recognition;CVPR)正在如火如荼地进行中,来自世界各地的计算机视觉研究者和工程师都在这里分享最新的进展。

对于今年的CVPR大会,谷歌人工智能团队共有近70份论文获得了收录,并介绍了在计算机视觉的一系列研究,包括对象映射与渲染,3D人类姿态生成,语义分割和透明对象关键点估计等等。

下面是或能用于增强现实/虚拟现实领域的论文及相关摘要整理:

1. Local Deep Implicit Functions for 3D Shape

这个项目的目标是通过深度摄像头视图推断来学习一个实现精确表面重建,紧凑存储,高效计算,相似形状一致性,以及不同形状类别归纳的3D形状表示。为此,我们引入了局部深隐函数(LDIF),一种将空间分解为一组结构化的学习隐函数的三维形状表示。我们提供从三维网格或姿势深度图像推断空间分解和局部深度隐式函数的网络。

2. GHUM & GHUML: Generative 3D Human Shape and Articulated Pose Models

我们在一个完全可训练的、模块化的深度学习框架内提出了一个活节3D人类建模管道。通过以各种姿势拍摄高分辨率的人体三维扫描,再加上头部和面部表情的特写镜头,以及手部关节,以及初步的、由艺术家设计的、性别中立的四边形网格,并且使用变分自编码、位姿空间变形校正、骨架关节中心预测器和混合蒙皮函数,我们在一个一致的学习循环中训练包括非线性形状空间在内的所有模型参数。所述模型与所有的三维动态扫描数据同时进行训练,从而获取相关性并确保各种组件的一致性。模型支持面部表情分析,以及身体(手部细节)形状和姿势估计。我们提供了完全可训练的,包含不同分辨率的通用人体模型,对它们进行了比较,分析了不同组件的影响,并用图像数据说明了它们的重建。

相关论文:GHUM & GHUML: Generative 3D Human Shape and Articulated Pose Models

3. Deep Homography Estimation for Dynamic Scenes

单应性估计是许多计算机视觉问题中的一个重要步骤。近年来,深层神经网络方法比传统方法更有利于解决所述问题。然而,新方法没有考虑输入图像中的动态内容,只用可以完全对齐的图像对来训练神经网络。本文探讨了如何设计和训练处理动态场景的深层神经网络。我们首先收集一个具有动态内容的大型视频数据集。然后我们开发了一个多尺度神经网络,并证明当使用我们的新数据集进行适当训练时,所述神经网络能够在一定程度上处理动态场景。为了估计动态场景的单应性,我们需要识别动态内容。由于动态内容检测和单应性估计是两个紧密耦合的任务,所以我们遵循多任务学习原理,扩展了我们的多尺度网络,使之能够联合估计动态掩码和单应性。实验结果表明,所述方法能够很好地估计具有动态场景、模糊伪影或缺少纹理的复杂场景的单应性。

4. 3D-MPA: Multi Proposal Aggregation for 3D Semantic Instance Segmentation

我们提出了一种基于三维点云的实例分割方法3D-MPA。在给定输入点云的情况下,我们提出了一种以对象为中心的方法,其中每个点为其对象中心投票。我们从预测的对象中心采样对象建议。然后,我们从投票给同一对象中心的分组点特征中学习建议特征。图卷积网络引入了建议间关系,除了lower-level的点特征外,还提供higher-level的特征学习。每个proposal都包含一个语义标签、一组关联点,而我们在关联点定义了一个前景背景掩码、一个对象评分和聚合特性。以前的研究通常对proposal执行非最大抑制(NMS),以获得最终的对象检测或语义实例。然而,NMS可以丢弃潜在的正确预测。相反,我们的方法保留所有proposal,并根据所学的聚合特征将它们组合在一起。在ScanNetV2基准和S3DIS数据集上,我们发现它在三维目标检测和语义实例分割任务上优于NMS,并且优于现有的最新方法。

相关论文:3D-MPA: Multi Proposal Aggregation for 3D Semantic Instance Segmentation

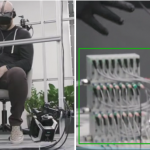

5. KeyPose: Multi-View 3D Labeling and Keypoint Estimation for Transparent Objects

估计桌面对象的三维姿态对于机器人操作等应用至关重要。解决这个问题的众多现有方法都需要一个用于训练和预测的对象深度映射。在这篇论文中,我们放弃使用深度传感器,转而使用原生立体输入。我们解决了两个问题:第一,我们建立了一个用RGB摄像头在桌面对象捕捉和标记3D关键点的简单方法;第二,我们开发了一个名为KeyPose的深层神经网络,它可以从立体输入中学习使用3D关键点来精确地预测对象姿势,甚至可以用于透明对象。为了评估我们方法的性能,我们创建了一个由15个清晰对象组成的数据集。我们训练实例和类别模型,并显示对新纹理、姿势和对象的归纳。KeyPose在3D姿势估计方面超过了其他先进的方法。立体输入对于这种性能至关重要,因为它比使用单目输入提高了2倍的效果。我们将发布数据捕获和标记管道、透明对象数据库、KeyPose模型和评估代码的公共版本。

相关论文:KeyPose: Multi-View 3D Labeling and Keypoint Estimation for Transparent Objects

6. DOPS: Learning to Detect 3D Objects and Predict their 3D Shapes

我们提出了一种快速的单级三维目标检测方法DOPS。以前的方法通常会做出特定领域的设计决策,例如在自动驾驶场景中将点投影到鸟瞰图中。相比之下,我们提出了一种通用方法,它既适用于室内场景,也适用于室外场景。我们方法的核心之处是一种快速的单通道架构,它既能检测三维对象,又能估计对象的形状。三维边界框参数在每一个点上一次估计,通过图形卷积进行聚合,并输入网络的一个分支。在合成数据集上学习潜在形状空间和形状解码器,并将其作为三维目标检测管道端到端训练的监督。因此,我们的模型能够在不访问目标数据集中的基本真实形状信息的情况下提取形状。

相关论文:DOPS: Learning to Detect 3D Objects and Predict their 3D Shapes