Unit AR Foundation开始支持ARKit 4新功能

现已支持ARKit 4

(映维网 2020年06月25日)新款iPad Pro搭载的LiDAR扫描仪能够提供增强的场景理解和现实世界深度信息,从而将AR体验的真实感提升了一个档次。针对这一点,Unity扩展了开发工具AR Foundation,增加了包含这一全新深度数据和场景集合的ARKit 3.5和ARKit 4新功能。

AR Foundation现在支持下面的新功能:

-

自动环境遮挡

-

深度图像

-

场景重建

1. 自动环境遮挡

运行ARKit 4的iPad Pro为每一帧生成一个深度图像。深度图像中的每个像素指定设备与真实对象之间的扫描距离。

AR Foundation 4.1包含的AR Occlusion Manager在渲染背景时会合并所述深度信息。当渲染camera背景时,背景渲染器将根据深度图像中的数据更新深度缓冲区。如果虚拟内容比真实内容更接近camera时,虚拟对象会在虚拟场景渲染时遮挡真实世界。同样,当虚拟内容远离真实世界对象,虚拟内容将不会渲染到所述像素,亦即物理对象遮挡虚拟内容。

下面这个视频演示了自动环境遮挡是如何改进虚拟内容和真实世界内容的视觉集成:

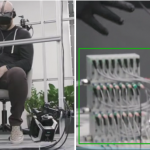

2. 深度图像

开发者同时可以获取原始数据并进行基于CPU的额外处理。AR Foundation 4.1允许用户直接访问包含深度图像的像素数据,并将其用于自定义应用行为或输入至计算机视觉算法。

彩色图像(左)和深度图像(右)的并排对比

3. 场景重建

利用新款iPad Pros搭载的LiDAR传感器,ARKit场景重建可以扫描环境,并创建代表真实环境的网格几何。另外,ARKit在扫描网格中提供了每个三角形的可选分类。逐三角形分类标识与三角形现实世界位置相对应的曲面类型。

Arkit3.5和ArFoundation4.0引入了场景重建,而后者主要是通过ARMeshManager操作。当扫描环境时,ARMeshManager在虚拟场景中构建网格几何,而所述网格几何可以通过多种方式予以利用,包括为物理提供碰撞几何。

下面这个视频演示了网格分类功能(不同颜色表示不同分类的曲面类型),以及用作与虚拟对象进行物理交互的碰撞几何的网格:

AR Foundation和ARKit XR Plugin Package的4.1版本包含所需的一切,并与Unity 2019 LTS和更高版本兼容。你可以在GitHub发现一个演示如何设置自动遮挡的AR Foundation示例。

一如既往,如果你存在任何问题,请随时通过Unity Handhled AR论坛留下你的反馈和意见。